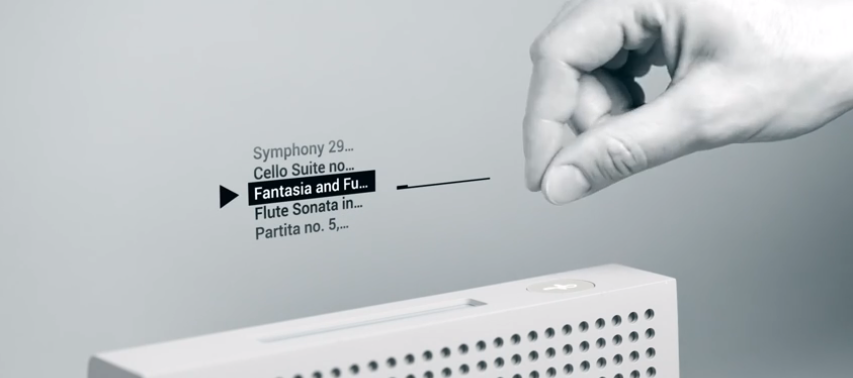

参考画像:Welcome to Project Soli|YouTubeスクリーンショット

■近い将来リモコンや物理ボタンはなくなる!?|Project Soli・ViBand

「Fairy Lights in Femtoseconds」落合陽一さんインタビュー:「アートはもうテクノロジーでしかなくなる」

(2015/8/17、ギズモード)

落合電波、次は電波です。去年くらいからずっと言ってるんですけど今はまだ手探り。最近だと、グーグルのATAP研究チームがやっている電波インタラクションの研究「Project Soli」。これをアップデートする新しいホログラフィック電波みたいなものが作れると、人間の入力にも出力にも使えますよね。あれでLEDを点けようとか彼らは思ってないかもしれないけど、そんなワンホップが加わったらおもしろい。

Project Soli: Alpha Developers Showcase

未来では、リモコンやデバイスを使わずに何かを動かすためには、体の中に埋め込むようになるかもしれないと漠然と考えてきましたが、「Project Soli」の動画を見ると、別のアプローチの仕方(物理的に触れることなく、レーダーで動作を感知して、ボタンを押したりボリュームを上げ下げする)も考えられているようです。

ViBand: High-Fidelity Bio-Acoustic Sensing Using Commodity Smartwatch Accelerometers

また、「ViBand」では、スマートウォッチの加速度センサーを活用し、フリック、クラップ、スクラッチ、タップなどのハンドジェスチャを動作のシグナルとして使うというアプローチを行なっています。

Touché: Enhancing Touch Interaction on Humans, Screens, Liquids, and Everyday Objects

キミは知っているか? 魔法の世界を創り出すディズニー・リサーチを (3/3)

(2013/7/10、MONOist)

基本的な動作原理のポイントは、「交流信号は常に信号の周波数に基づいた、最もインピーダンスの低い経路をとる」という特性にある。例えば、ある物体を、指1本で触れている状態、手のひらを押し当てている状態、2本の指でつまんでいる状態とでは、人の体に流れる電流の通り道が変化し、それぞれ異なる周波数パターンを持つ。Touchéは、この異なる周波数パターンを、あらかじめマシンラーニングシステムで学習しておくことで、ただ1つのセンサーでどのように触れているかを把握できるシステムだ。

ディズニーリサーチがて「世界全体をインタラクティブにしたい」という考えのもと、開発しているのがセンシング技術「Touché」(「トゥシェ」)です。

例えば、触れ方のパターン(異なる周波数パターン)を学習させておけば、スマホに触れずに動かすことができる仕組みです。

■まとめ

パソコン時代の「クリック」「ドロップ&ドラッグ」からスマホ時代の「フリック(画面を上下左右にさっと払う)」「スワイプ(上下左右に画面を送る)」「タップ(ポンッと叩く・触れる)」「ピンチイン(2本の指で狭める・つまむ→画面サイズの縮小)」「ピンチアウト(2本の指で広げる→画面サイズの拡大)」となり、AR・VR・MR時代には新しい操作が必要となってくるでしょう。

「触感」が変える未来のインターフェース【FUJITSU JOURNAL(富士通ジャーナル)】

舌で車いすやパソコン操作する方法を開発|米ジョージア工科大で紹介した米ジョージア工科大などの研究チームが開発したのは、脊髄損傷などで頭部しか動かせなくなった人が舌でパソコンや車いすを操作する方法です。

Georgia Tech Tongue Drive System

Tongue Drive – Patty West – GE FOCUS FORWARD

舌に小さな磁石を留めて、磁気センサーで磁石の動きを感知し、動きに合わせて車いすなどを制御する仕組みですが、舌で操作する技術のメリットは、舌はより素早く、器用に動かせるということがあげられるそうです。

つまり、舌を使った操作というアイデアも可能性の一つとして考えられます。

SFの世界を見ると、操作をする際に様々なジェスチャーが使われています。

映画「アイアンマン」に登場するロバート・ダウニーJrが演じるトニー・スタークが人工知能「JARVIS(ジャーヴィス)」を操作する際の動きのようになるのでしょうか?

映画「マイノリティ・リポート」でジョン・アンダートン(トム・クルーズ)が操作をするような感じになるのでしょうか?

はたまた「攻殻機動隊 STAND ALONE COMPLEX」の世界観のように電脳とつながって意識で操作するようになるのでしょうか?

F8:Facebookは頭脳直結テキスト入力開発中―「埋込み手術の必要なし」と元DARPA局長がプレゼン

(2017/4/20、TechCrunch)

頭脳をコンピューターと直結するインターフェイスは、最終的にはVR〔拡張現実〕にも利用され、物理的なコントローラーを操作することなしに、思考だけでVRを操作できるようになるという。このインターフェイスは脳を毎秒100回スキャンして光学画像を生成し、人が声に出さずに思考している内容を読み取ってテキスト化する。

Facebookのチームは、頭脳への電極等の埋め込みを必要なしに、頭脳と直結してテキスト入力などができるコンピューター・インターフェイスを開発しているそうです。

レギーナ・ドゥーガン 「マッハ20のグライダーからハチドリロボットまで」

【参考リンク】

- Elon Musk’s Neuralink wants to boost the brain to keep up with AI(2017/3/27、TechCrunch)

【参考リンク】

- VR、AR、BMI、IoA…、脳とデジタルの新しい関係に迫る~理化学研究所 藤井直敬氏(2016/3/21、電通報)

もしかしたら、考えただけで操作をすることができるようになるような、脳波などを読み取って機械を操作するブレイン・マシン・インターフェース(Brain-machine Interface : BMI)が私たちが想像しているよりも早く実現する日も近いかもしれません。

P.S.

だけど、物理的にバンドの伸縮性を利用したインターフェイスも同時に面白いなと感じてしまいます。

【関連記事】